Сборщик данных

Многие считают сборщика данных простым инструментом, который автоматизирует рутинные задачи. И это так, отчасти. Но я бы сказал, что это гораздо больше – это фундамент для любой современной аналитики и машинного обучения. У нас в ООО Аньхуэй Чжихуань технологии, мы сталкиваемся с этим каждый день, и, честно говоря, хороший сборщик данных – это редкость. Особенно, если говорить не просто о переносе данных из одного места в другое, а о создании надежной, масштабируемой и контролируемой системы. Хочу поделиться своими наблюдениями и некоторыми уроками, которые мы вынесли.

Что на самом деле делает сборщик данных?

Вначале все сводится к простому: чтение данных из различных источников – баз данных, API, логов, файлов… Но это лишь верхушка айсберга. Реальная сложность возникает при обеспечении качества, надежности и безопасности этих данных. Нам часто приходилось сталкиваться с ситуацией, когда кажется, что все работает, но данные 'грязные' – некорректные значения, пропуски, дубликаты. И это уже требует дополнительных усилий по очистке и валидации. Затем, конечно, вопрос интеграции – как объединить данные из разных источников, которые могут быть в разных форматах и структурах? Здесь уже потребуются умение работать с различными форматами данных (CSV, JSON, XML, Parquet и т.д.) и понимание семантики этих данных. И конечно, мониторинг – чтобы понимать, что происходит с потоком данных, выявлять и устранять проблемы на ранней стадии.

Ошибочно думать, что сборщик данных – это исключительно вопрос программирования. Да, знания Python, Java или Go необходимы, но не менее важны понимание предметной области, знание структуры данных и алгоритмов обработки информации. Без этого рискуешь получить сложную, но бесполезную систему.

Вызовы интеграции разнородных источников

У нас в компании часто встречаются задачи интеграции данных из legacy систем и современных облачных платформ. Это, как правило, самый сложный этап. Приходится учитывать разные протоколы, API и форматы данных. Недавно мы работали над проектом, где нужно было интегрировать данные из старой CRM-системы, которая использовала устаревший формат хранения, с новой облачной базой данных. Это потребовало написания специализированных парсеров и преобразователей данных, а также разработки сложной логики для обработки ошибок и исключений. В результате, мы смогли получить единый источник данных, который можно использовать для аналитики и отчетов.

Один из самых распространенных вызовов – это обеспечение консистентности данных. Например, один и тот же объект может иметь разные значения в разных системах. Как решить эту проблему? Нужно разработать четкие правила для разрешения конфликтов и обеспечить их автоматическое применение. Это может потребовать создания сложных алгоритмов для сопоставления и слияния данных.

Практические инструменты и подходы

Выбор инструмента для сборки данных зависит от конкретной задачи. Существует множество вариантов: от простых скриптов на Python до специализированных ETL-инструментов (Extract, Transform, Load). Мы часто используем Apache Kafka для потоковой обработки данных, Airflow для оркестровки задач и dbt для transformations данных. Для работы с API часто используют библиотеки requests, для работы с базами данных – psycopg2, SQLAlchemy и т.д. Выбор конкретных инструментов – это всегда компромисс между функциональностью, производительностью и стоимостью.

Нам особенно нравится гибкость и возможности настройки, которые предоставляют инструменты с открытым исходным кодом. Это позволяет нам адаптировать их под наши конкретные нужды и избежать зависимости от коммерческих решений. Однако, стоит учитывать, что работа с такими инструментами требует больше усилий по настройке и поддержке.

Автоматизация мониторинга и оповещений

Мониторинг сборщика данных – это критически важная задача. Нужно понимать, что происходит с потоком данных, выявлять и устранять проблемы на ранней стадии. Мы используем Prometheus и Grafana для мониторинга производительности сборщика данных и оповещений об ошибках. Также, мы настроили автоматические оповещения по email и Slack, чтобы оперативно реагировать на любые проблемы.

Автоматизация мониторинга позволяет нам сократить время простоя системы и избежать потери данных. Кроме того, она помогает нам выявлять узкие места и оптимизировать производительность сборщика данных.

Использование message queues для повышения надежности

Использование message queues, таких как Kafka или RabbitMQ, значительно повышает надежность сборщика данных. Если какой-то компонент системы выходит из строя, данные не теряются, а остаются в очереди и обрабатываются позже. Это позволяет обеспечить непрерывность обработки данных и избежать потери информации.

Мы часто используем message queues для обработки больших объемов данных, которые поступают из разных источников. Это позволяет нам отделить сбор данных от обработки и обеспечить масштабируемость системы.

Реальный опыт: проект по сбору данных с датчиков IoT

Недавно мы участвовали в проекте по сбору данных с датчиков IoT для мониторинга состояния оборудования на производстве. Это был сложный проект, который потребовал интеграции данных из множества различных источников – датчиков, систем управления производством, баз данных. Мы использовали Kafka для потоковой обработки данных, Airflow для оркестровки задач и Apache Spark для обработки больших объемов данных. В результате, мы смогли создать систему, которая позволяет в режиме реального времени отслеживать состояние оборудования и выявлять потенциальные проблемы.

Этот проект показал, что хороший сборщик данных – это не просто техническая задача, а комплексная задача, которая требует понимания предметной области, умения работать с различными инструментами и технологий, а также опыта решения реальных проблем.

Итоги и рекомендации

В заключение хочу сказать, что сборщик данных – это не просто инструмент для автоматизации, а архитектура знаний. Это фундамент для любой современной аналитики и машинного обучения. Нам в ООО Аньхуэй Чжихуань технологии удалось наработать определенный опыт в этой области, и мы всегда готовы поделиться им с другими.

Мои рекомендации: Начинайте с четкого определения требований к системе. Выбирайте инструменты, которые соответствуют вашим потребностям и задачам. Автоматизируйте мониторинг и оповещения. Не забывайте про качество данных. И, самое главное, не бойтесь экспериментировать и учиться на своих ошибках.

Мы постоянно работаем над улучшением наших инструментов и процессов, чтобы предоставлять нашим клиентам наилучшие решения для сбора данных. Если у вас есть какие-либо вопросы, пожалуйста, свяжитесь с нами.

ООО Аньхуэй Чжихуань технологии активно внедряет передовые технологии в области обработки данных, включая решения для IoT и машинного обучения. Команда обладает обширным опытом в разработке и внедрении комплексных систем сбора, обработки и анализа данных. Наша цель – помочь компаниям принимать обоснованные решения на основе данных.Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

VS301 Акустический датчик вибрации и температуры

VS301 Акустический датчик вибрации и температуры -

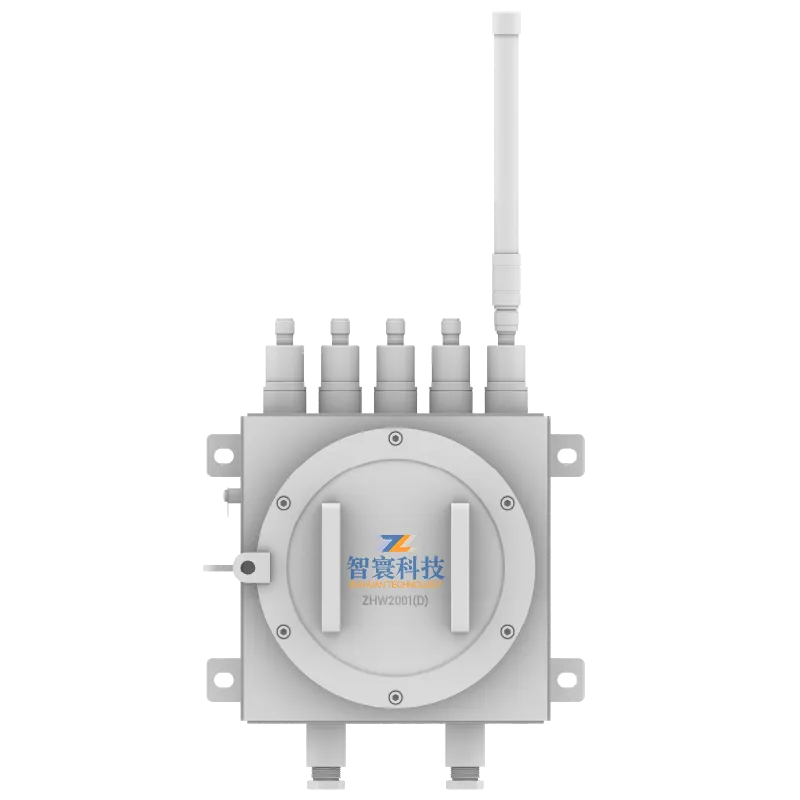

ZHW2001D Взрывозащищенный и искробезопасный беспроводной сборщик данных

ZHW2001D Взрывозащищенный и искробезопасный беспроводной сборщик данных -

YJC127W Взрывозащищенный и искробезопасный беспроводной регистратор данных для использования в шахтах

YJC127W Взрывозащищенный и искробезопасный беспроводной регистратор данных для использования в шахтах -

ZHY1101 5G -версия многофункционального проводного блока сбора данных

ZHY1101 5G -версия многофункционального проводного блока сбора данных -

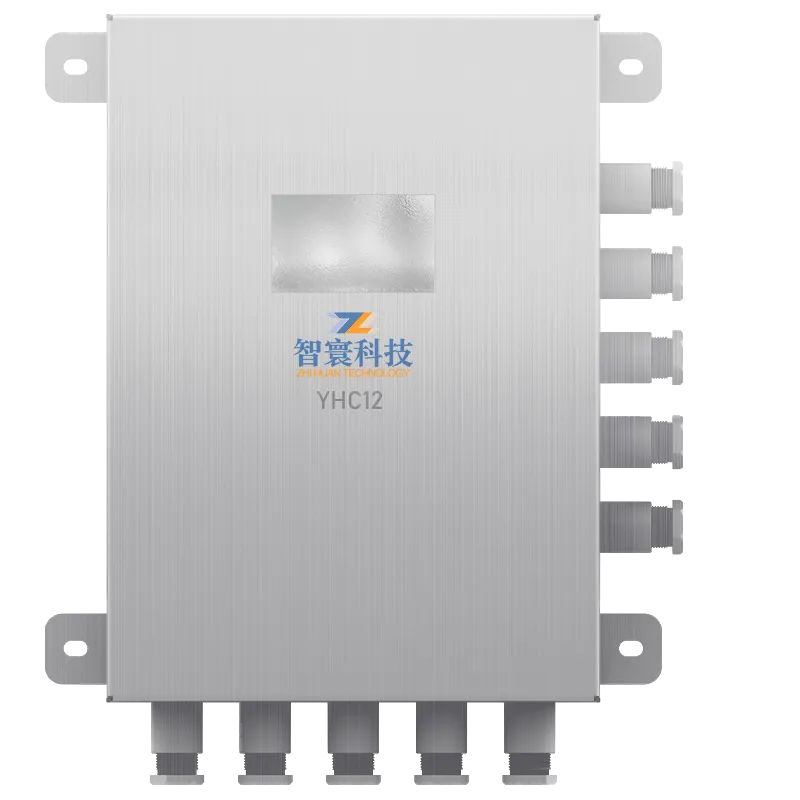

YHC12 Искробезопасный сборщик данных для горнодобывающей промышленности

YHC12 Искробезопасный сборщик данных для горнодобывающей промышленности -

Беспилотная система инспекции

Беспилотная система инспекции -

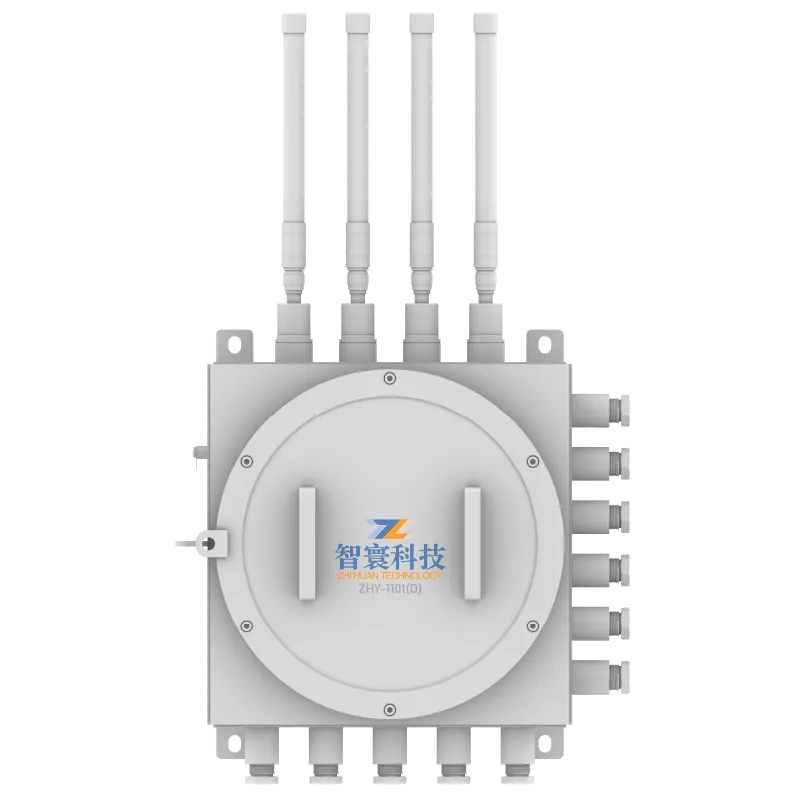

ZHY-1101(D)Взрывозащищенный и искробезопасный проводной регистратор данных

ZHY-1101(D)Взрывозащищенный и искробезопасный проводной регистратор данных -

ZHW803P-4G Трехосный беспроводной датчик вибрации и температуры

ZHW803P-4G Трехосный беспроводной датчик вибрации и температуры -

Облачная платформа диагностики машинного интеллекта

Облачная платформа диагностики машинного интеллекта -

GBY1000W Беспроводной датчик вибрации для применения в горнодобывающей промышленности

GBY1000W Беспроводной датчик вибрации для применения в горнодобывающей промышленности -

ZHW2001 Беспроводной регистратор данных

ZHW2001 Беспроводной регистратор данных -

ZHY601(T) Проводной датчик вибрации всех частот

ZHY601(T) Проводной датчик вибрации всех частот

Связанный поиск

Связанный поиск- Внедрение цифрового двойника цена

- Мониторинг безопасности персонала цена

- Взрывозащита завод

- Взрывозащищенное электрооборудование с искробезопасными цепями завод

- Китай система цифровой двойник основный покупатель

- Китай мониторинг дутьевых вентиляторов флотационных машин поставщик

- Мониторинг дутьевых вентиляторов производитель

- Мониторинг главного вентилятора поставщик

- Мониторинг подъемных насосов поставщики

- Китай линейка программных продуктов