Китай интеллектуальные алгоритмы

Когда слышишь про ?китайские интеллектуальные алгоритмы?, сразу представляются либо панацея от всех проблем, либо подозрительные черные ящики. На деле же — это просто инструменты, которые в умелых руках творят чудеса, а в неумелых генерируют отчеты с красивыми графиками и нулевой практической пользой.

Почему вибрация и акустика — не то, чем кажутся

Вот смотрите: почти двадцать лет назад, когда мы только начинали работать с диагностикой оборудования, все сводилось к простым FFT-анализам. Сейчас же — любой частотный спектр надо пропускать через пачку фильтров, иначе шумы съедают полезный сигнал. В интеллектуальных алгоритмах для вибродиагностики главная проблема — не точность, а интерпретируемость. Можно натренировать нейросеть с 99% точностью распознавать дефекты подшипников, но когда она ошибается — никто не понимает почему.

На одном из металлургических комбинатов под Челябинском мы как-то полгода собирали данные с дымососов. Алгоритм стабильно показывал ?норму?, пока внезапно не сработала аварийная защита. Оказалось, модель научилась игнорировать медленно нарастающий дефект — потому что в обучающей выборке таких случаев не было. Пришлось пересматривать весь подход к балансировке классов.

Кстати, именно после этого случая мы в ООО Аньхуэй Чжихуань технологии начали внедрять гибридные системы: классические физические модели + машинное обучение для калибровки в реальном времени. Не идеально, но хотя бы понятно, где и почему возникает расхождение.

Машинное зрение в промышленности: где алгоритмы спотыкаются

Сейчас модно говорить про компьютерное зрение для контроля качества. Но в реальных условиях на том же автомобильном заводе — постоянная запыленность, вибрация, меняющееся освещение. Стандартные архитектуры типа YOLO или ResNet здесь работают через раз.

Помню, на конвейере по сборке двигателей пытались детектировать микротрещины на блоке цилиндров. Алгоритм, обученный на чистых данных, выдавал 40% ложных срабатываний из-за теней от такелажного оборудования. Пришлось разрабатывать кастомный препроцессинг с адаптивной бинаризацией — не самое элегантное решение, но хотя бы стабильно работающее.

Вот здесь подробности нашего подхода: zhkjtec.ru — там как раз разбираем кейс с сегментацией дефектов в условиях зашумленных изображений. Не хочу сказать, что мы придумали что-то революционное, но хотя бы честно описали все костыли и временные решения.

Энергетика — полигон для интеллектуальных алгоритмов

В энергосекторе особенно заметна разница между ?лабораторными? и промышленными алгоритмами. Прогнозирование нагрузки — классическая задача, но когда начинаешь учитывать температуру, влажность, даже расписание массовых мероприятий в городе — все становится значительно сложнее.

На одной ТЭЦ в Сибири внедряли систему предиктивного обслуживания турбин. Алгоритм вроде бы учитывал все: вибрацию, температуру подшипников, качество масла. Но не учли сезонные колебания напряжения в сети — модель постоянно ?переобучалась? на артефактах измерений.

Интересно, что иногда простые линейные модели с правильно подобранными фичами работают лучше сложных ансамблей. В китайских интеллектуальных алгоритмах последнего поколения как раз появилась тенденция к упрощению — не в ущерб точности, а для повышения надежности.

Нефтехимия: где данные дороже алгоритмов

В нефтепереработке главная проблема — не в разработке сложных моделей, а в получении репрезентативных данных. Когда технологический процесс идет месяцами без остановки, собрать достаточное количество примеров аномалий практически невозможно.

На установке каталитического крекинга в Татарстане мы два года собирали данные просто чтобы получить хотя бы 50 примеров штатных остановок и 3 — аварийных. При таком дисбалансе даже самые продвинутые интеллектуальные алгоритмы начинают вести себя неадекватно.

Пришлось разрабатывать синтетические данные на основе физического моделирования процессов. Не идеально, но хотя бы дает какое-то подобие тренировочной выборки. Кстати, этот опыт потом пригодился и в угольной промышленности — там похожие проблемы с редкими событиями.

Металлургия: специфика высокотемпературных процессов

В цветной металлургии особенно важна устойчивость алгоритмов к экстремальным условиям. Датчики near-infrared диапазона на прокатных станах постоянно выходят из строя, а без их показаний все модели летят в тартарары.

На алюминиевом заводе в Красноярске как-то пришлось экстренно переключаться на резервные алгоритмы, когда основной модуль перестал адекватно работать из-за скачка температуры. Выяснилось, что в обучении не учли тепловое расширение измерительных головок — мелочь, которая стоила недели простоя.

Сейчас в ООО Аньхуэй Чжихуань технологии для таких случаев всегда держим упрощенные модели-дублеры. Они менее точные, но зато устойчивые к изменениям условий. Иногда надежность важнее точности.

Автомобилестроение: вызовы массового производства

На конвейерах автозаводов скорость принятия решений часто важнее их оптимальности. Алгоритм, который за 50 миллисекунд дает ответ с 95% точностью, лучше чем тот, что за 200 миллисекунд выдает 99%.

При внедрении системы контроля сварных швов в Набережных Челнах столкнулись с интересным эффектом: операторы начали слепо доверять алгоритму и пропускать очевидные дефекты. Пришлось вводить элемент случайности в интерфейс — система иногда ?сомневается? в заведомо хороших образцах, чтобы человек не терял внимание.

Это к вопросу о том, что интеллектуальные алгоритмы — не замена людям, а инструмент. Без правильной интеграции в рабочие процессы даже самая совершенная модель бесполезна.

Что в сухом остатке

За десять с лишним лет практики в разных отраслях понял главное: не бывает универсальных решений. То, что работает в энергетике, бесполезно в автомобилестроении. Алгоритмы должны создаваться под конкретную задачу и конкретные условия.

Сейчас много говорят про transfer learning и другие методы универсализации, но на практике — каждый раз приходится начинать почти с нуля. Разве что какие-то общие принципы остаются: важность качества данных, интерпретируемость моделей, резервирование на случай сбоев.

Если кому-то интересны детали — заходите на zhkjtec.ru, там мы как раз делимся не только успехами, но и неудачами. Потому что именно на ошибках учатся — и люди, и алгоритмы.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

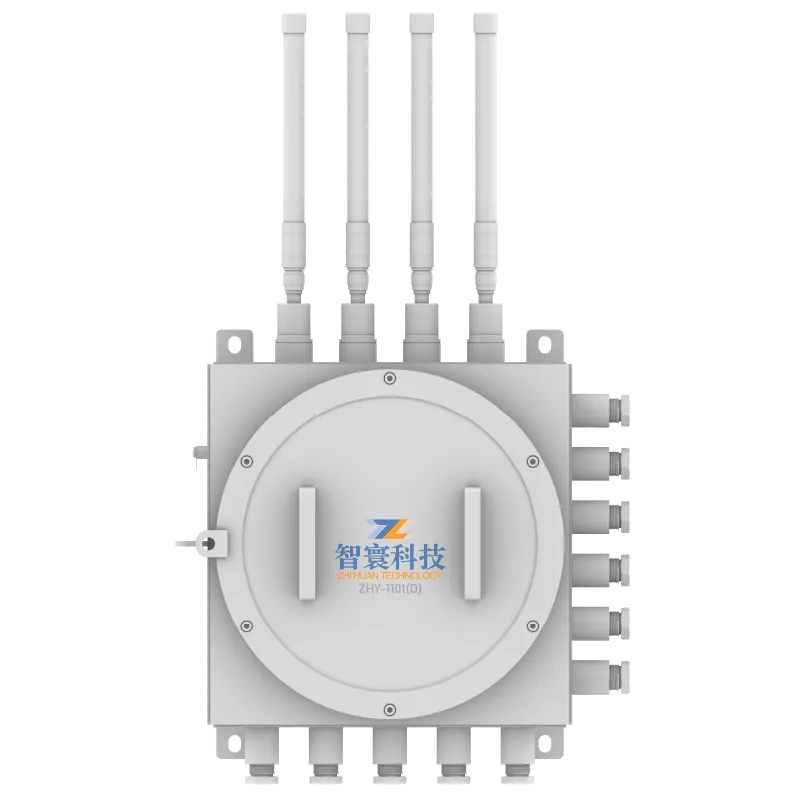

ZHY-1101(D)Взрывозащищенный и искробезопасный проводной регистратор данных

ZHY-1101(D)Взрывозащищенный и искробезопасный проводной регистратор данных -

ZHW801 Беспроводной интегрированный датчик вибрации и температуры

ZHW801 Беспроводной интегрированный датчик вибрации и температуры -

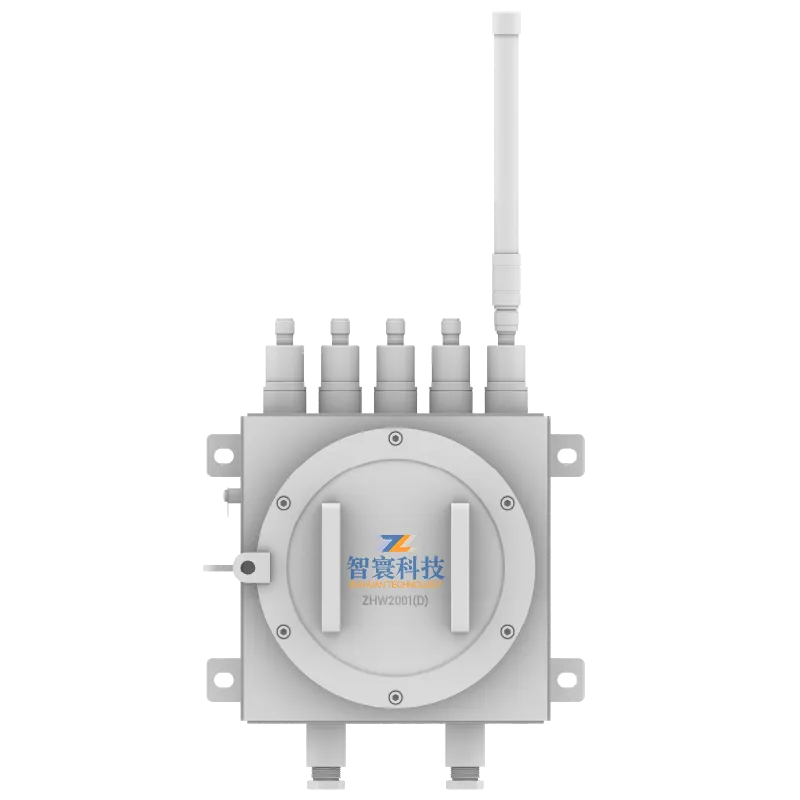

ZHW2001 Беспроводной регистратор данных

ZHW2001 Беспроводной регистратор данных -

VS301 Акустический датчик вибрации и температуры

VS301 Акустический датчик вибрации и температуры -

ZHW803P 3-осевой беспроводной встроенный датчик вибрации и температуры

ZHW803P 3-осевой беспроводной встроенный датчик вибрации и температуры -

ZHY601(T) Проводной датчик вибрации всех частот

ZHY601(T) Проводной датчик вибрации всех частот -

YJC127W Взрывозащищенный и искробезопасный беспроводной регистратор данных для использования в шахтах

YJC127W Взрывозащищенный и искробезопасный беспроводной регистратор данных для использования в шахтах -

Машинная аналитика данных

Машинная аналитика данных -

GBY1000W Беспроводной датчик вибрации для применения в горнодобывающей промышленности

GBY1000W Беспроводной датчик вибрации для применения в горнодобывающей промышленности -

Беспилотная система инспекции

Беспилотная система инспекции -

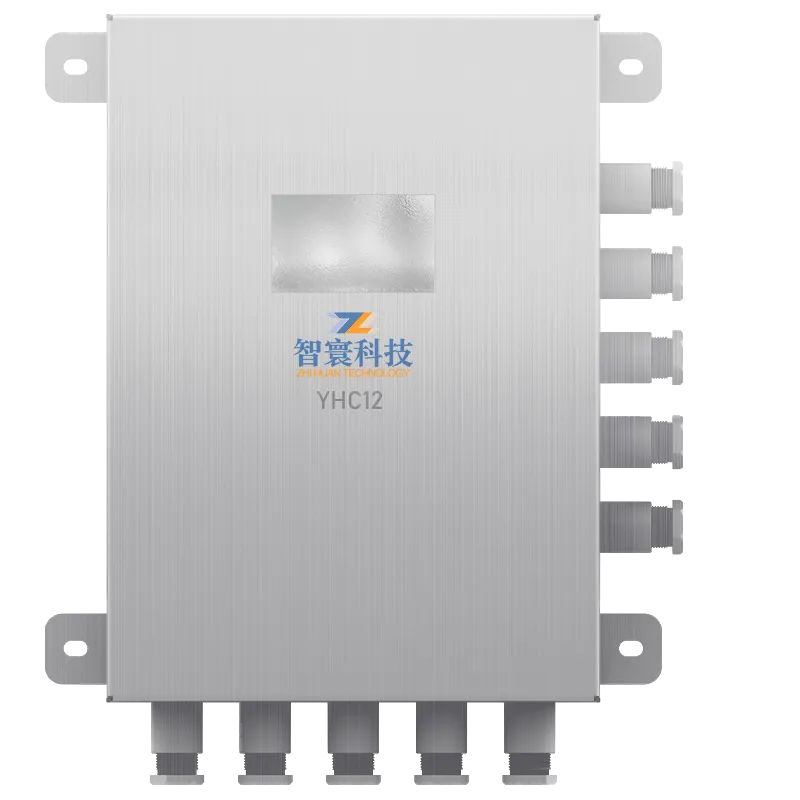

YHC12 Искробезопасный сборщик данных для горнодобывающей промышленности

YHC12 Искробезопасный сборщик данных для горнодобывающей промышленности -

ZHW2700 Промышленный 5G-маршрутизатор

ZHW2700 Промышленный 5G-маршрутизатор

Связанный поиск

Связанный поиск- Использование цифрового двойника поставщик

- Мониторинг вентиляторов пылеудаления заводы

- Китай мониторинг безопасности окружающей среды заводы

- Китай интеллектуальная система управления и обслуживания оборудования

- Интеллектуальные алгоритмы поставщик

- Мониторинг предотвращения разрыва ленты заводы

- Мониторинг вальцового пресса производитель

- Китай беспилотный контроль централизованная платформа управления цена

- Интеллектуальный цифровой двойник завод

- Китай система контроля